access数据库负载量有多大?会崩溃吗?

发布:站生 | 发布时间: 2012年3月30日access数据库负载量有多大?会崩溃吗?近日在群里有网友在讨论access数据库的负载量问题,意见不一,那么我们该选择哪种数据库呢?有的网友主推php+mysql,在做站的时候选择mysql、sql等大型数据库,为了就是有一个好的负载量,避免因为数据量大而造成崩溃,那么我们的数据量究竟会有那么大吗?在这里蛐蛐工作室认为,对于一般的站点来说主推access,因为access管理方便,操作容易,服务器配置简单。对于一般中小型网站来说,选择access是完全没有问题的。如果你只是建一个企业站或者个人博客来用access,那更是完全没有问题的,有的人说Access数据库最大可以达到2G,也有说4G的,那么你知道2G是什么概念吗?

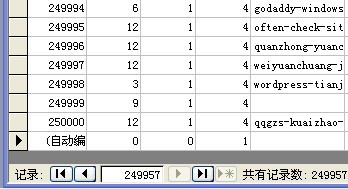

我们拿一个1G的access数据库和本博客的access为例,通过对blog_Article表中的数据复制粘贴到25万条记录数时,数据库达到998M,算下来,按每天十篇文章算,能够运营68年,对于一个中小型网站来说是足够了,至于说网站的访问量引起access查询慢的问题,我们可以考虑采用生成静态页面的方式来应付访问量大的站点。

下面是一篇从网上转来的文章,有兴趣的网友可以阅读一下:

记得几年前刚学程序的时候经常听看网络上留传的文章说ACCESS的极限是100M,超了性能就会直线下降,一直到现在都是这样,可以很轻易的找出很多关于ACCESS的是非常差的数据库的文章。

几年前我学习用ASP做新闻系统由于ACCESS是最方便的数据库(我认为是最方便的),当时用的就是ACCESS+ASP的组合,当时心里想反正做了这个东西我的站访问量低对ACCESS应该也可以满足要求。(直到今天我还是用ACCESS+ASP的组合)

最近几年给很多企业做了不少的网站,也全是ACCESS,不过做的过程中的思想就一个,ACCESS是性能低下的数据库,不适合做高访问量的站来使用。这种思想一直延续到去年接了一个站点活。这个网站原先的结构是ASP+SQL,属于行业类网站,每天访问量不是很高大约日/IP2000左右,浏览量1~2万次左右,但数据量很高,有超过15万条数据。这个客户在我们公司做了百度和3721,那段时间他的站所在的服务器频繁死机,最后服务器管理员确认是他的网站有问题,最终找到我希望我可以帮他解决问题。我接手后先分析了他原先数据的结构,发现很多字段都是多余的,也没使用关系,甚至有的数据表连索引也没有,总之问题多多。后来我对数据库数据和程序进行了优化处理经过测试可以达到每天10万次以上不会出现服务器死掉的状况。(开了多个页使用META连续刷新一天)值得注意的是这次我用的数据库是ACCESS而不是原先的SQL。

至此我彻底对ACCESS性能底下的看法有了很大改观,一至于我现在自己的一个小站也是用ACCESS,目前数据库已经600多M了,性能目前还不错,一般每天浏览量在20~30万次左右,服务器CPU占用在15%上下。

写到这里我并不是贬低SQL,事实上SQL的确比ACCESS强我不否认。我认为一个一个数据库的好坏很大程度上取决于一个程序员有没有真正了解数据用好数据库,有没有针对程序做好优化,程序是否合理。

在这里我想问问非常熟悉ACCESS的朋友,ACESS到底能承受什么样的极限参数才会性能严重下降?如果是SQL又能承受多少?

数据库量小,只是少量用户访问时,access比sql要快得多,access没有sql占资源多,但数据量多了,access就不能做复杂的查询了,会出错!时间多了就会崩溃掉!

从上面可以看出,数据库和访问量不大的站点采用access来做为数据库是完全没问题的,欢迎在下面发表自己的意见。

- 相关文章:

手动配置Mysql,无需安装的方法以及Mysql的一些基本命令 (2009-10-18 18:15:38)

发表评论

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。